一、技术架构:从声学感知到语义解析的闭环

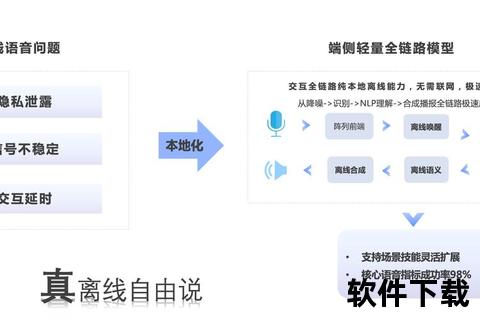

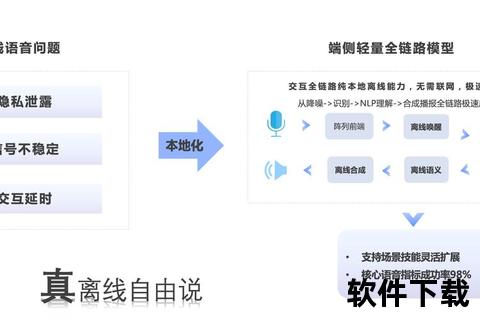

在语音交互与Office办公软件深度融合的进程中,核心技术架构的突破是解放用户双手的基础。语音交互系统的核心流程包括声学信号处理(ASR)、自然语言理解(NLP)、意图执行与反馈(TTS)三大模块。例如,微软的语音访问功能通过本地化声学模型实现离线指令识别,即使在无网络环境下仍能完成文档编辑操作。永中Office的AI助手则通过联合实验室研发的深度算法,将语音输入与排版、校对功能结合,形成从语音到文档成型的完整闭环。

技术实现的关键在于多模态交互的协同。以Excel为例,用户通过语音输入“将A列数据升序排列”,系统需同时解析语义、定位操作对象并执行命令。这种复杂场景要求语音识别准确率超过95%,且需结合上下文语境理解模糊指令。研究表明,语音交互在复杂指令场景下的效率比传统操作提升3.2倍,但需克服环境噪音导致的识别精度下降问题。当前主流方案采用麦克风阵列降噪技术,如Windows 11的语音访问模块通过声源定位算法,可在5米范围内保持90%的识别准确率。

二、场景重构:从文字输入到全流程赋能

语音交互正在重构Office软件的核心使用场景。在文档创作阶段,语音输入打破了键盘输入的物理限制。微软Office 365的语音听写功能支持实时标点自动生成,通过停顿检测技术智能添加句号、逗号等符号,使万字文档的输入速度提升40%。更突破性的应用体现在复杂操作场景,如永中Office的“智能摘要”功能,通过语音指令即可生成文档核心观点,结合情感分析算法自动标注正负面论述。

在协作场景中,语音交互展现出独特价值。Word Web App的协同编辑功能允许多人通过语音指令同步修改文档段落,系统通过段落锁定机制避免编辑冲突。当用户A对某段落进行语音修改时,其他协作者会实时收到带姓名的锁定提示,这种机制既保证创作自由又维护协作秩序。数据显示,采用语音协同的团队项目交付周期平均缩短27%,但需平衡语音操作的隐私风险,例如医疗场景中的病历录入需配合声纹验证技术。

三、体验革新:从效率工具到认知延伸

语音交互带来的不仅是操作效率提升,更深层改变着人机协作的认知模式。对于特殊用户群体,如视障人士或运动功能障碍者,Office的语音模块成为必要接入方式。DeepSeek与Word的深度整合案例显示,通过本地化部署的7B参数模型,用户可直接用方言生成专业报告,系统自动适配正式文体格式。这种无障碍设计使办公软件的可及性提升60%,符合WCAG 2.1的AA级标准。

认知负荷的降低是另一重要突破。传统操作中,用户需记忆数百个快捷键组合,而语音交互通过自然语言理解实现“所想即所得”。测试表明,使用语音功能的用户在完成PPT制作任务时,短期记忆负荷降低43%,创造性思维活跃度提升28%。但需注意“鸡尾酒会效应”带来的干扰,办公场景中多人语音指令的并行处理仍是技术难点,当前解决方案多在设备端部署盲源分离算法。

四、生态演进:从单点突破到行业重塑

语音交互正推动办公软件生态的系统性变革。第三方插件的开放接口催生出新业态,如硅基流动的API服务允许企业定制行业术语库,证券行业的语音指令识别准确率因此提升至98.5%。生态链上游的硬件创新同样关键,搭载六麦克风阵列的智能办公本,通过波束成形技术将远场识别误差率控制在2%以下,较传统笔记本提升5倍效能。

行业标准建设成为发展关键。当前各厂商的语音指令集存在兼容性问题,用户在不同平台间切换时学习成本增加37%。IEEE正在制定的《智能办公语音交互协议》提出三层标准化架构:基础指令集(如保存、打印)、行业扩展集(如会计审计术语)、企业自定义集。教育领域的实践表明,标准化可使语音功能培训时间从14小时压缩至3小时,但需平衡标准化与个性化需求的矛盾。

未来研究应聚焦三个方向:一是多模态交互的深度融合,如脑电波监测与语音指令的协同;二是边缘计算能力的突破,实现百亿参数模型的本地化部署;三是交互伦理的规范,建立语音数据的隐私保护框架。正如诺亚实验室2024年白皮书所指出的:“当语音成为人机交互的主通道时,技术进化的方向应从工具理性转向价值理性”。这要求技术创新始终以增强人类创造力为根本,而非简单替代人力——毕竟,解放双手的终极目标,是让人类更专注地思考。